Un escenario tradicional en la ciencia ficción del siglo XX y de principios del XXI consiste en que las máquinas, representadas por su mayor exponente, los robots, deciden que los humanos, a pesar de ser sus creadores, no tienen la capacidad para optimizar el mundo que los rodea e incluso son un riesgo para ellos mismos y para la civilización. Por lo que en aras de salvar el legado de la humanidad y a la humanidad misma, los robots toman el control y con sus fríos cálculos deciden eliminar o controlar a los humanos para poder continuar con la misión o el legado mismo encargado por los humanos. Generalmente se nos da a entender que los robots no entendieron bien su misión, los objetivos o más profundamente, no entienden al ser humano, porque, a pesar de haber sido creados por humanos, no lo son y nunca podrán serlo.

Resumiendo. Las máquinas, robots, inteligencia artificial, que están realizando labores que la parte racional de los humanos les encargaron, se dan cuenta que los humanos tenemos emociones (aspectos primitivo de nuestro cerebro) como el odio, la envidia y la violencia, las cuales ponen en riesgo la misión encomendada y para salvaguardar la misión deciden eliminar esas emociones, pero como son cánceres con metástasis, no hay más remedio que sacrificar a la humanidad y continuar con el legado humano valioso (el racional). Pero siendo ficción humana, pues siempre triunfa el amor y esta inteligencia emocional o robots son reducidos a chatarra y los humanos seguimos dando rienda suelta a nuestras emociones primarias.

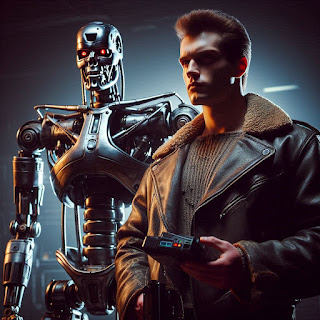

Ejemplos hay muchos: HAL 9000 la computadora de la nave en "2001, odisea en el espacio" de Stanley Kubrick que tiene el dilema de cumplir la misión o salvar a la tripulación. Skynet de "Terminator" es una inteligencia diseñada para la defensa de EEUU en una guerra nuclear y llega a la conclusión de que sin humanos no hay amenaza nuclear. Además de que un ataque hacia Skynet significa un intento de evitarle cumplir su misión. Por último, aunque los ejemplos son demasiados mencionaré a Mother de "I am Mother", robot que tiene la misión de crear a la niña perfecta que repoblará la tierra después del apocalipsis y al tratar de cumplir su misión hace cosas que para nuestra interpretación emocional están mal.

Entonces, si la inteligencia artificial hará todo lo posible, por cumplir los objetivos que se le asignen y no se desviará por ideologías y emociones, creo que todo el problema se basa en plantearnos los objetivos correctos y en el marco teórico de conocimientos que deben tener estas IA para hacer la toma de decisiones en la medida en que vayan surgiendo obstáculos que deben de irse superando. Los 3 ejemplos que puse: HAL9000, Skynet y Mother tenían un "background" limitado para la toma de decisiones que tenían que hacer, de ahí que no tuvieron todas las variables o matices, necesarios para tomar las decisiones óptimas para los humanos (fueron las óptimas para sus objetivos iniciales, pero no hubo retroalimientación).

Creo que una IA que tenga objetivos claros, un "background" dinámico y retroalimentación sería más eficiente que una inteligencia humana (políticos y mandatarios) con problemas de ideología y emocionales.

Estos objetivos a los que me refiero, no son la conquista del espacio, hacer el humano perfecto o defender a EEUU de una guerra nuclear, sino cosas más necesarias e inmediatas como coadyuvar a la administración de justicia para reducir al mínimo las decisiones emocionales de jueces y jurados. Cuestiones jurídicas comerciales, tramitología del gobierno, manejo, logística y transporte de medicinas y alimentos. Transparencia y acceso a la información, entre otras cosas que podrían ayudar a mejorar nuestra vida paso a paso.

Como sentencia Yuval Noah Harari, en su libro " Sapiens, De animales a Dioses", los robots, la inteligencia artificial son nuestra creación y si los humanos desaparecemos y ellos siguen, serán entonces la humanidad, porque son nuestra creación. Es difícil imaginar la humanidad sin humanos, pero si reflexionamos sobre qué es la humanidad, luego entonces nos daremos cuenta que no ésta no podría quedar en mejores manos.

No hay comentarios:

Publicar un comentario